Finalmente la versione 9.0.0 del programma digiKam è stata rilasciata e funziona ottimamente nei miei PC Linux.. Questa versione principale introduce miglioramenti rivoluzionari in termini di prestazioni, usabilità ed efficienza del flusso di lavoro, con particolare attenzione alla modernizzazione dell'interfaccia utente, al miglioramento della gestione dei metadati e all'espansione del supporto per nuovi modelli di fotocamere e formati di file.

The post digiKam 9.0.0 è stato rilasciato con nuove funzionalità first appeared on Il mondo di Paolettopn (IV3BVK - K1BVK).09 March 2026

03 March 2026

Linux Ubuntu: ora sudo visualizza gli asterischi quando si digita la password

Paolo Garbin (paolettopn)

Linux Ubuntu 26.04 rompe una storica tradizione del comando di terminale; ora il comando di amministrazione sudo mostra gli asterischi quando si digita la password.

The post Linux Ubuntu: ora sudo visualizza gli asterischi quando si digita la password first appeared on Il mondo di Paolettopn (IV3BVK - K1BVK).25 February 2026

È arrivata la nuova versione 148.0 di Thunderbird con delle novità e diversi aggiornamenti

Paolo Garbin (paolettopn)

Ieri è stata pubblicata la nuova versione Desktop di Thunderbird (la versione 148i.0 a 64 bit). Ci sono diverse novità, oltre ad aver risolto velocemente alcuni bugs di funzionamento, con grande vantaggio per molti utilizzatori!

The post È arrivata la nuova versione 148.0 di Thunderbird con delle novità e diversi aggiornamenti first appeared on Il mondo di Paolettopn (IV3BVK - K1BVK).14 January 2026

È arrivata la nuova versione 15.0 di Thunderbird Mobile con diversi aggiornamenti

Paolo Garbin (paolettopn)

Una settimana fa è stata pubblicata la nuova versione dell'App Android Thunderbird Mobile (la versione 15.0). La speranza che venissero risolti velocemente alcuni piccoli ma fastidiosi bugs di funzionamento è stata ben riposta!

The post È arrivata la nuova versione 15.0 di Thunderbird Mobile con diversi aggiornamenti first appeared on Il mondo di Paolettopn (IV3BVK - K1BVK).

È arrivata la nuova versione 147.0 di Thunderbird con una novità e diversi aggiornamenti

Paolo Garbin (paolettopn)

Ieri è stata pubblicata la nuova versione Desktop di Thunderbird (la versione 147.0 a 64 bit). C'è una grossa novità, oltre ad aver risolto velocemente alcuni bugs di funzionamento, con grande vantaggio per molti utilizzatori!

The post È arrivata la nuova versione 147.0 di Thunderbird con una novità e diversi aggiornamenti first appeared on Il mondo di Paolettopn (IV3BVK - K1BVK).10 December 2025

È arrivata la nuova versione 14.0 di Thunderbird Mobile con diversi aggiornamenti

Paolo Garbin (paolettopn)

Qualche settimana fa è stata pubblicata la nuova versione dell'App Android Thunderbird Mobile (la versione 14.0). La speranza che venissero risolti velocemente alcuni piccoli ma fastidiosi bugs di funzionamento è stata ben riposta!

The post È arrivata la nuova versione 14.0 di Thunderbird Mobile con diversi aggiornamenti first appeared on Il mondo di Paolettopn (IV3BVK - K1BVK).

È arrivata la nuova versione 146.0 di Thunderbird con una novità e molti aggiornamenti

Paolo Garbin (paolettopn)

Ieri è stata pubblicata la nuova versione Desktop di Thunderbird (la versione 146.0 a 64 bit). C'è una grossa novità, oltre ad aver risolto velocemente alcuni bugs di funzionamento, con grande vantaggio per molti utilizzatori!

The post È arrivata la nuova versione 146.0 di Thunderbird con una novità e molti aggiornamenti first appeared on Il mondo di Paolettopn (IV3BVK - K1BVK).14 November 2025

Si rinnova anche quest’anno la storica collaborazione tra l'Associazione culturale informatica Pordenone Linux User Group (PN LUG) Aps e Pordenone Fiere SpA, per portare all'evento della Fiera del Radioamatore 2 l'edizione invernale della la nostra Linux Arena 2.

The post PN LUG e IV3 RadioLab alla Linux Arena 2 della Fiera Radioamatore2 di PN first appeared on Il mondo di Paolettopn (IV3BVK - K1BVK).Ieri è stata pubblicata la nuova versione Desktop di Thunderbird (la versione 145.0 a 64 bit). Sono stati risolti velocemente alcuni fastidiosi bugs di funzionamento, con grande vantaggio per molti utilizzatori!

The post È arrivata la nuova versione 145.0 di Thunderbird con molti aggiornamenti first appeared on Il mondo di Paolettopn (IV3BVK - K1BVK).24 October 2025

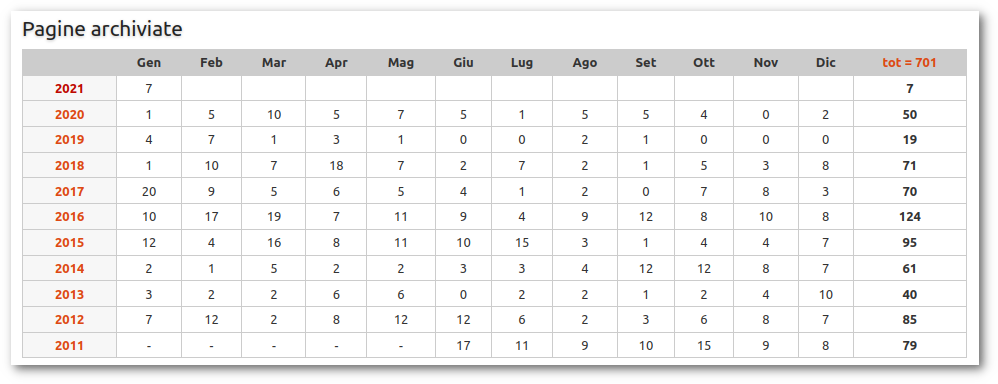

Ebbene si, è successo. Il contatore delle guide revisionate ha varcato quota MILLLEEEEEEEE!

Vi rendete conto? No eh? Allora partiamo dall'inizio per chi si fosse perso qualcosa 😉

In questo sito qui https://wiki.ubuntu-it.org in modo simile a quanto succede su Wikipedia, gli utenti italiani del sistema operativo Ubuntu possono scrivere guide sugli argomenti più disparati riguardanti l'utilizzo del sistema. Come installare quel particolare programma o il sistema operativo stesso, come settare una macchina virtuale o installare i driver della stampante, e così via...

Questo può farlo un qualsiasi utente, qui c'è scritto come fare.

Esiste poi uno staff che interviene per fare in modo che le pagine siano inserite nei punti giusti della documentazione e per uniformarne gli standard. Bene, nella primavera del 2011 in seguito a una riorganizzazione interna fu creata questa pagina per tenere traccia dei lavori. In cima alla tabella della Pagine archiviate c'è un contatore delle pagine revisionate, che durante il mese di Ottobre 2025 ha raggiunto quota... MILLLEEEEEEEE!

Forse ora capirete l'entusiasmo 😊

E ci sembra opportuno ringraziare tutti quelli che sono intervenuti e si sono impegnati per aggiungere ogni volta un tassello in più al nostro wiki. Pertanto linkiamo il faraonico resoconto di ogni annata, da Giugno 2011 a Ottobre 2025: 2011 2012 2013 2014 2015 2016 2017 2018 2019 2020 2021 2022 2023 2024 2025

Grazie di cuore a tutti! ♥️

A cura del Gruppo Doc

Vuoi contribuire al Wiki? Comincia subito!

È arrivata la nuova versione 13.0 di Thunderbird Mobile con molti aggiornamenti

Paolo Garbin (paolettopn)

Ieri è stata pubblicata la nuova versione dell'App Android Thunderbird Mobile (la versione 13.0). La speranza che venissero risolti velocemente alcuni piccoli ma fastidiosi bugs di funzionamento è stata ben riposta!

The post È arrivata la nuova versione 13.0 di Thunderbird Mobile con molti aggiornamenti first appeared on Il mondo di Paolettopn (IV3BVK - K1BVK).05 October 2025

È disponibile la newsletter N° 024/2025 della comunità di ubuntu-it. In questo numero:

- Ecco a voi il secondo snapshot di Ubuntu 25.10

- In che modo Livepatch viene protetto dagli attacchi dei malintenzionati?

- Una nuova sinergia per rafforzare la collaborazione tra Debian e Canonical: nasce Debcrafters

- Full Circle Magazine Issue #218 in inglese

- Quando la storia dell'informatica si incontra e viene raccontata con una foto

- La community di KDE ascolta i suoi utenti e disattiva un effetto pericoloso

- Aggiornamenti di sicurezza

- Bug riportati

- Statistiche del gruppo sviluppo

- Scrivi per la newsletter

Puoi leggere direttamente la newsletter oppure scaricarla in formato pdf. Se hai perso i numeri precedenti, puoi trovarli nell'archivio! Per ricevere la newsletter ogni settimana nella tua casella di posta elettronica, iscriviti alla lista newsletter-italiana.

È disponibile la newsletter N° 023/2025 della comunità di ubuntu-it. In questo numero:

- Ubuntu corre ai ripari, individuate due vulnerabilità critiche in UDisks e libblockdev

- GNOME finalmente corregge un bug storico

- Apple scommette su Linux e lo fa rilasciando uno strumento ufficiale per creare container Linux su Mac

- Svolta cruciale nel mondo open source: il governo della Danimarca dice addio a Microsoft e punta tutto su Linux e LibreOffice

- Mozilla chiude il suo Deepfake AI Detector

- Linux 6.16-RC3 cresce a ritmo costante tra sviluppo, bugfix e riflettori sulla qualità del codice

- Aggiornamenti di sicurezza

- Bug riportati

- Statistiche del gruppo sviluppo

- Scrivi per la newsletter

Puoi leggere direttamente la newsletter oppure scaricarla in formato pdf. Se hai perso i numeri precedenti, puoi trovarli nell'archivio! Per ricevere la newsletter ogni settimana nella tua casella di posta elettronica, iscriviti alla lista newsletter-italiana.

È disponibile la newsletter N° 022/2025 della comunità di ubuntu-it. In questo numero:

- Si avvicina l'EOL per Ubuntu 24.10 “Oracular Oriole”: come prepararsi al meglio

- La nuova era della sincronizzazione oraria di Ubuntu

- Ubuntu 25.10 punta sul linguaggio Rust

- Anche Ubuntu 24.04 si adegua alle normative europee sulla gestione energetica

- Full Circle Magazine Issue #217 in inglese

- Aggiornamenti di sicurezza

- Bug riportati

- Statistiche del gruppo sviluppo

- Scrivi per la newsletter

Puoi leggere direttamente la newsletter oppure scaricarla in formato pdf. Se hai perso i numeri precedenti, puoi trovarli nell'archivio! Per ricevere la newsletter ogni settimana nella tua casella di posta elettronica, iscriviti alla lista newsletter-italiana.

È disponibile la newsletter N° 021/2025 della comunità di ubuntu-it. In questo numero:

- Ubuntu si prepara a ridurre il peso dei pacchetti firmware

- Ubuntu Touch OTA-9, scopriamo assieme le nuove funzionalità

- Il futuro della prossima release del kernel Linux inizia con una valanga di novità

- How to del mese: MacBook con Linux e nessun suono? Ecco come risolvere il temuto "Dummy Output"

- Aggiornamenti di sicurezza

- Bug riportati

- Statistiche del gruppo sviluppo

- Scrivi per la newsletter

Puoi leggere direttamente la newsletter oppure scaricarla in formato pdf. Se hai perso i numeri precedenti, puoi trovarli nell'archivio! Per ricevere la newsletter ogni settimana nella tua casella di posta elettronica, iscriviti alla lista newsletter-italiana.

01 October 2025

È disponibile la newsletter N° 020/2025 della comunità di ubuntu-it. In questo numero:

- Nuova vulnerabilità corretta in Apport su Ubuntu

- Rivoluzione nel ciclo di sviluppo di Ubuntu, arrivano le Monthly Snapshots

- Ubuntu 25.10 passa a Sudo basato su Rust

- Canonical corregge un fastidioso bug presente nel Software Updater

- Ubuntu integra un nuovo supporto avanzato per le GPU Intel

- Chiude una delle riviste più iconiche del mondo open source: addio a Linux Format

- Linux 6.15: il kernel che guarda al futuro tra Rust, performance e sicurezza

- Aggiornamenti di sicurezza

- Bug riportati

- Statistiche del gruppo sviluppo

- Scrivi per la newsletter

Puoi leggere direttamente la newsletter oppure scaricarla in formato pdf. Se hai perso i numeri precedenti, puoi trovarli nell'archivio! Per ricevere la newsletter ogni settimana nella tua casella di posta elettronica, iscriviti alla lista newsletter-italiana.

È disponibile la newsletter N° 019/2025 della comunità di ubuntu-it. In questo numero:

- Canonical annuncia grandi cambiamenti per l'Ubuntu Summit

- Arriva una nuova estensione su GNOME che permette la regolazione della luce notturna dello schermo

- Addio a Pocket

- Il clone della Touch Bar di Apple, Flexbar, ora supporta Linux

- Aggiornamenti di sicurezza

- Bug riportati

- Statistiche del gruppo sviluppo

- Scrivi per la newsletter

Puoi leggere direttamente la newsletter oppure scaricarla in formato pdf. Se hai perso i numeri precedenti, puoi trovarli nell'archivio! Per ricevere la newsletter ogni settimana nella tua casella di posta elettronica, iscriviti alla lista newsletter-italiana.

È disponibile la newsletter N° 018/2025 della comunità di ubuntu-it. In questo numero:

- Ora puoi aggiornare la tua distribuzione da Ubuntu 24.10 a Ubuntu 25.04 in pochi secondi

- Canonical investe nei grandi progetti open source

- Ubuntu 25.10 rinnoverà il proprio ambiente con una nuova app per il terminale e per visualizzare le immagini

- Ripartono gli aggiornamenti dopo lo stop forzato per Ubuntu 25.04

- GNOME sostituisce il lettore video Totem con Showtime

- Firefox permette un'ulteriore personalizzazione dello sfondo della nuova scheda

- Aggiornamenti di sicurezza

- Bug riportati

- Statistiche del gruppo sviluppo

- Scrivi per la newsletter

Puoi leggere direttamente la newsletter oppure scaricarla in formato pdf. Se hai perso i numeri precedenti, puoi trovarli nell'archivio! Per ricevere la newsletter ogni settimana nella tua casella di posta elettronica, iscriviti alla lista newsletter-italiana.

È disponibile la newsletter N° 017/2025 della comunità di ubuntu-it. In questo numero:

- Arrivano le prime build di Ubuntu 25.10

- Attivare e disattivare i controlli sul benessere in Ubuntu non è mai stato così facile

- L'ossigeno di Firefox per restare in vita nel 2025

- Anche i sistemi GNU/Linux hanno diversi programmi di pulizia, uno di questi si chiama BleachBit

- Taglio di prezzo e nuove opportunità per i maker: ecco come si presenta Raspberry Pi Compute Module 4

- LibreOffice 25.2.3 è ora disponibile con 68 correzioni di bug

- Aggiornamenti di sicurezza

- Bug riportati

- Statistiche del gruppo sviluppo

- Scrivi per la newsletter

Puoi leggere direttamente la newsletter oppure scaricarla in formato pdf. Se hai perso i numeri precedenti, puoi trovarli nell'archivio! Per ricevere la newsletter ogni settimana nella tua casella di posta elettronica, iscriviti alla lista newsletter-italiana.

È disponibile la newsletter N° 016/2025 della comunità di ubuntu-it. In questo numero:

- Ubuntu 24.04 conquista l'edge computing: arriva il supporto desktop per la piattaforma Qualcomm Dragonwing

- Inizia lo sviluppo della prossima versione di Ubuntu 25.10 "Questing Quokka"

- Gli sviluppatori Debian cercano una soluzione generale per i modelli di intelligenza artificiale

- Il futuro della progettazione delle interfacce GTK passa per Blueprint

- Rust e QEMU pronti per una rivoluzione riguardante l'emulazione del futuro

- Addio al supporto DAX in EXT2

- Nuove difese di sicurezza per il kernel Linux 6.16

- Aggiornamenti di sicurezza

- Bug riportati

- Statistiche del gruppo sviluppo

- Scrivi per la newsletter

Puoi leggere direttamente la newsletter oppure scaricarla in formato pdf. Se hai perso i numeri precedenti, puoi trovarli nell'archivio! Per ricevere la newsletter ogni settimana nella tua casella di posta elettronica, iscriviti alla lista newsletter-italiana.

27 September 2025

È disponibile la newsletter N° 015/2025 della comunità di ubuntu-it. In questo numero:

- Come prolungare la vita di Ubuntu 20.04 grazie a ESM

- Un piccolo bug mette alla prova Ubuntu 25.04

- Ubuntu guarda al futuro: Coreutils riscritte in Rust in vista di Ubuntu 25.10

- GNOME 48.1 migliora l'HDR e perfeziona l'esperienza desktop

- Linux ottimizza il futuro della crittografia e arriva il refactoring di SHA256

- Linux 6.15-RC4 risolve il fastidioso bug delle memorie da 32 GB

- Aggiornamenti di sicurezza

- Bug riportati

- Statistiche del gruppo sviluppo

- Scrivi per la newsletter

Puoi leggere direttamente la newsletter oppure scaricarla in formato pdf. Se hai perso i numeri precedenti, puoi trovarli nell'archivio! Per ricevere la newsletter ogni settimana nella tua casella di posta elettronica, iscriviti alla lista newsletter-italiana.

03 May 2024

Can I modify a commercetools Order price?

Short answer: no.

commercetools offers some update actions on the Order itself, but none of them helps you in case you want to change the Order price.

And that’s the reason why we will use Order Edits.

What are Order Edits, then?

As per the commercetools official documentation, here’s the Order Edits definition:

OrderEdit are containers for financial changes after an Order has been placed.

If no financial aspect of an Order should be changed, use Update Order, which does not perform a recalculation. If no Deliveries or Payments occurred, you can alternatively replicate the Order as a new Cart.

commercetools Order Edits documentation

A simple strategy to modify the order price

Imagine the following scenario:

- Invoice Issued: Your company issues an invoice for 2016.90€.

- Payment Made: The client pays the invoice via bank transfer after several days.

- Price Adjustment: Due to increased product prices, the order is placed with a total price of 2997.90€.

- Misalignment: There is a misalignment of 81€ between the invoice amount and the current order price.

The simplest strategy is to apply a Direct Discount.

A Direct Discount represents a CartDiscount that is only associated with a single Cart or Order.

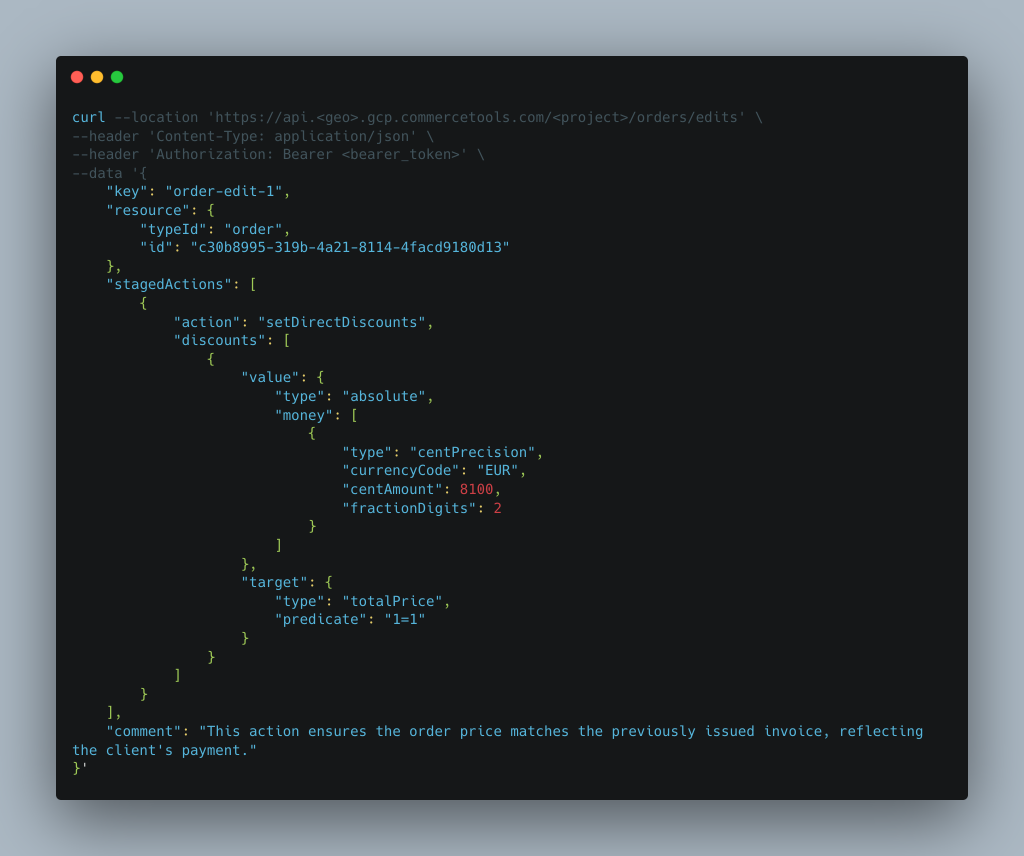

Create an OrderEdit

In this code we specify:

- a key (try to give consistent names, guaranteeing sequential keys, because duplicate keys are not tolerated)

- a resource: that’s our order

- stagedActions array

- setDirectDiscounts action to set a direct discount related to the totalPrice with an absolute amount of 81€

- comment: it’s always a good choice to document your action, because Orders are sensitive entities and they should be rarely modified

We obtain a JSON representing the newly created OrderEdit.

The JSON is easy to read.

What’s important is to keep the OrderEdit ID and the OrderEdit version for the next call.

The OrderEdit type should be set to PreviewSuccess.

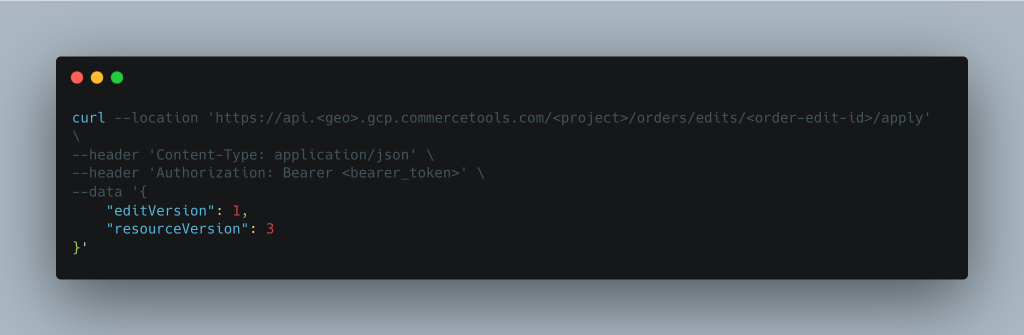

Apply the OrderEdit

We can now apply the OrderEdit:

We will just pass the OrderEdit ID in the URL, and the OrderEdit version plus the Order version in the body.

That’s it!

In the result you should see an important result section like this:

"result": {

"type": "Applied",

"appliedAt": "2024-05-03T11:09:08.051Z"

[...]sto confirm that it’s applied.

The result section also reports the previous and current state of the OrderEdit resource, respectively in the excerptBeforeEdit and excerptAfterEdit section:

"excerptBeforeEdit": {

"totalPrice": {

"type": "centPrecision",

"currencyCode": "EUR",

"centAmount": 209790,

"fractionDigits": 2

},

[...]

},

"excerptAfterEdit": {

"totalPrice": {

"type": "centPrecision",

"currencyCode": "EUR",

"centAmount": 201690,

"fractionDigits": 2

},

[...]

}And that’s it.

The post Unlocking commercetools: Modifying Order Prices Made Simple appeared first on L.S..

25 April 2023

Foto originale: Multiverse by manuej

È appena uscita, ancora fresca di rilascio, la nuova versione del sistema operativo di Canonical: Ubuntu 23.04 nome in codice Lunar Lobster. L'avete già provata o installata? Benché sia una release intermedia, si è rivelata molto attesa poiché include parecchie novità. Per citarne solo alcune:

-

Il nuovo installer

- GNOME 44

- Il kernel Linux 6.2

-

Il nuovo flavor Ubuntu Cinnamon e il gradito ritorno di Edubuntu

Per approfondire potete leggere questo articolo.

Come sempre il Gruppo Documentazione ha organizzato le attività di revisione di tante pagine wiki (come ad esempio quella che contiene i link di download delle varie edizioni e derivate).

Ma il lavoro non è ancora terminato. Infatti chi ha già installato la nuova versione può contribuire aggiornando oppure segnalando nel forum le pagine che possono considerarsi già valide con Ubuntu 23.04 o che hanno bisogno di essere modificate.

Fine del supporto standard per Ubuntu 18.04 LTS

Questo mese che volge al termine vede anche concludersi il supporto "regolare" per l'ormai storica Ubuntu 18.04 LTS Bionic Beaver. Ciò vuol dire che sulle pagine verificate soltanto con questa versione comparirà l'apposito "bollino rosso", che avverte il lettore che la guida non è verificata da molto tempo. Anche in questo caso siete invitati a contribuire aggiornando o segnalando le pagine.

Infatti spesso tante guide (ad esempio quelle nella sezione Notebook) sono valide anche per le versioni successive di Ubuntu, perciò occorrerà effettuare una modifica rapida e semplicissima (sarà sufficiente aggiungere cinque soli caratteri: «23.04») 😉.

Welcome dd3my!

Approfittiamo di questo articolo per dare il benvenuto nel gruppo Documentazione all'utente dd3my. Lui non è di certo un nome nuovo all'interno della community di Ubuntu-it. Infatti da anni partecipa attivamente ai gruppi Newsletter, Marketing e Promozione, oltre che dare una mano abitualmente con il Wiki. Adesso potrà farlo ancor di più, ma in veste di editore del gruppo Doc.

Cogliamo infine l'occasione per ringraziare tutti i gli utenti volontari che ogni giorno contribuiscono al Wiki, chi in un modo chi in un altro. È grazie soprattutto a loro se nel 2022 siamo riusciti a scrivere (o a riscrivere) la bellezza di 110 guide, il numero più alto nell'ultimo quinquennio. Mica bruscolini! 😀

A cura del Gruppo Doc

Vuoi contribuire al Wiki? Comincia subito!

26 July 2021

Want to quit from a conversation with a bot provided through Dialogflow? You can use an Italian city, too.

Imagine that you go to the registry office.

The employee has to ask different questions, like your name, birthday, and so on.

He just asked the first one, you expect a lot more questions.

Second one

BOT: “What’s your first name?”

USER: “John”

BOT: “Sorry to hear that. Bye. Next, please!”

This is what I am going to tell you in this story, where our main character is not the employee but Google Dialogflow.

BOT: Where are you from?

USER: New York City

BOT: Sorry to hear this, bye!

Wait, what?

Imagine that a bot is asking a simple question “where are you from?”. You insert the correct value and BOOOM. The bot suddenly closes the conversation!

Overview

TIP: familiar with Dialogflow? Start from Conversation exits!

We use Google Dialogflow to provide a rich conversation experience to our customers, driving them through different Intents according to some data that we need them to submit and/or modify.

google.com – Intents

google.com – Intents

To give context to someone not used to Dialogflow, an Intent categorizes an end-user’s intention for one conversation turn. For each agent, you define many intents, where your combined Intents can handle a complete conversation. When an end-user writes or says something, referred to as an end-user expression, Dialogflow matches the end-user expression to the best intent in your agent.

When an intent is matched at runtime, Dialogflow provides the extracted values from the end-user expression as parameters.

Each parameter is described by different attributes, forming a parameter configuration. For this article, let’s say that we are interested at some point in the conversation in a parameter called city that has an Entity type @sys.geo-city.

That’s it. We ask for a parameter called city and we expect our user to write a city in his response:

“Los Angeles”

“I live in Los Angeles”

“I was in Los Angeles”

…

are all valid sentences for us: Los Angeles is extracted from the sentence and assigned to the parameter city.

Let’s finish this paragraph with the definition of Context: Dialogflow contexts are similar to natural language context. If a person says to you “they are orange”, you need context in order to understand what the person is referring to.

Conversation exits

Dialogflow has different features automatically provided that help you to create a rich conversation without having to reinvent the wheel.

System entities are one of these features.

Another important one is something called Conversation exits.

Some magic words will stop the conversation:

- “exit”

- “cancel”

- “stop”

- …

It’s impossible to avoid that this behavior happens, you can just apply some custom logic and reply one last time with a custom response.

Intent, parameters, conversation exits: a recap.

So, we are in a specific Intent, asking the user to give us a city name for our city parameter. At the same time, we know that some magic words will stop the conversation.

The Italian city that stops the conversation

Now we have all the elements to introduce the problem described in the article title. Our clients are from Italy, so the chat is in Italian, and 99.99% of the time the user is going to indicate an Italian city to our question.

One day, we had a support request from one of our clients: “When I insert the city where I live, the system replies with “OK, canceled. Goodbye.”.

-.-‘.

Open the logs.

Open the Dialogflow console.

Check the history.

Oh, wait, here it is! The city is called Fermo, and “Fermo!” means “Stop!”.

BOT: Can you please tell me where XYZ happened?

USER: Fermo

BOT: Sure, goodbye.

The user would be something like -.-‘ .

What the Dialogflow Support team told us about it

We tried to reach out to the Dialogflow support team.

This is the most important part of the email:

Conversational exits for Actions on Google(AoG) are implemented on the AoG app’s side and cannot be overridden by Dialogflow.

Unfortunately, our team is unable to assist as your question is more closely related to Actions on Google

What the Actions on Google Support Team told us about it

We can understand that the word “Fermo” is in reference to a city. However, it is also a system level hotword. Unfortunately there is no solution to bypass the system limitation. Please consider maybe using Fermo city / town or something along those lines, however that may not be guaranteed since it is a system hotword.

Read it again:

there is no solution to bypass the system limitation

Whaaaaat?? What we did

We provide the Dialogflow experience through the PHP Client library.

We created a list, that right now has only Fermo in it, of potentially dangerous cities.

When the user provides a single word response and we are in an Intent where we are asking for a city to extract a value for our @sys.geo-city parameter, we check if this word is in the list.

If so, we wrap the city in a context: “I live in <word>” before sending the response to Dialogflow.

There is no guarantee that this works, according to AoG support team response, but currently, it seems to work just fine.

The post The Italian city that STOPs Google Dialogflow appeared first on L.S..

26 March 2021

The Vision API now supports online (synchronous) small batch annotation (PDF/TIFF/GIF) for all features. To do so, the relevant documentation is Small batch file annotation online.

Let’s see how can we do this with PHP.

Context

Having PHP >= 7.4, the packages to require are:

google/cloud-vision google/cloud-storage

Code

How to upload the file in the storage

Soon.

Text detection

Even with PDFs we are going to use ImageAnnotatorClient, the service that performs Google Cloud Vision API detection tasks over client images and returns detected entities from the images.

$path = "gs://mystorage.com/path/to/my/file.pdf";

/* If you have it, you can give an hint about the language in the doc */

$context = new ImageContext();

$context->setLanguageHints(['it']);

/* Here's the annotator described before */

$imageAnnotator = new ImageAnnotatorClient();

/* We create an AnnotateFileRequest instance to annotate one single file */

$file_request = new AnnotateFileRequest();

/* We express our input file in terms of a GcsSource

instance the represents the Google Cloud Storage location */

$gcs_source = (new GcsSource())

->setUri($path);

/* Let's specify the feature we need. You can find the options below */

$feature = (new Feature())

->setType(Type::DOCUMENT_TEXT_DETECTION);

/* Let's specify the file info: a PDF in that location */

$input_config = (new InputConfig())

->setMimeType('application/pdf')

->setGcsSource($gcs_source);

/* Some configurations, including the pages of the file to perform image annotation. */

$file_request = $file_request->setInputConfig($input_config)

->setFeatures([$feature])

->setPages([1]);

/* Annotate the files and get the responses making the synchronous batch request. */

$result = $imageAnnotator->batchAnnotateFiles([$file_request]);

/* We take the first result, because that's 1 page only. */

$res = $result->getResponses();

$offset = $res->offsetGet(0);

$responses = $offset->getResponses();

$res = $responses[0];

/* Finally!!! The annotations! */

$annotations = $res->getFullTextAnnotation();

/* Clean up resources such as threads */

$imageAnnotator->close();

Features

In your request you can set the type of annotation you want to perform on the file. You can check the reference or the features list documentation.

Some examples are:

- Face detection

- Landmark detection

- Logo detection

- Label detection

- Text and document text detection

- ..

The post Google Vision: detect text in PDFs synchronously with PHP appeared first on L.S..

06 February 2021

Mavvvieeeeeniiii!!!! 🎉️🎊️🥂️🍾️

Perché tanto gaudio?

Semplice! Lo scorso Gennaio il wiki ha superato il traguardo delle 700 guide fra pagine create e ideate da Giugno 2011 a oggi 😊️

L'onore di tagliare tale traguardo è andato (anche giustamente) al nostro "uragano" wilecoyote, che arrivato da appena un anno ha messo in campo un impegno incredibile, rivelatosi provvidenziale per il proseguo del gruppo.

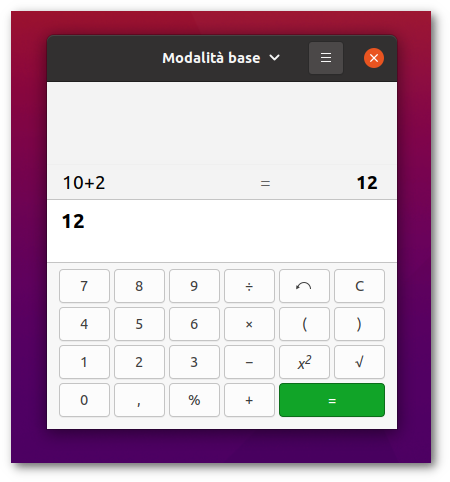

Tabella & conteggi

E andiamo per difetto, perché la nostra tabella non conteggia la miriade di piccole modifiche quotidiane o i ciclici e corposi lavori di routine fatti a ogni rilascio. Di fatto la pagina esiste per tenere facilmente traccia dei lavori svolti, il conteggio è più uno sfizio.

Già... il conteggio. Siamo pur sempre in ambito informatico e vi sarete chiesti quale stack utilizzassimo per effettuare questi calcoli statistici. Beh, cosa potremmo mai utilizzare se non lui... gnome-calculator! Implacabile e infallibile nell'eseguire somme su numeri naturali 😎️

Un grazie e prossimo traguardo...

Ma torniamo al wiki e soprattutto un pensiero a tutto il parco utenti. Da chi si è accorto e ha corretto piccoli errori a chi si è scervellato a scrivere guide complesse: un grazie di cuore all'impegno di tutti!

A Giugno ci sarà il decennale di questo ormai non più nuovo corso e sarà l'occasione per ripercorrere le tappe e le evoluzioni che bene o male, nonostante molte difficoltà, ci hanno permesso di arrivare qui e poter gridare: 700! 😀️

A cura del Gruppo Doc

Vuoi contribuire al Wiki? Comincia subito!

27 January 2021

|

Ad Aprile cesserà il supporto per Ubuntu 16.04. Fortunatamente i computer che funzionano con Ubuntu 16.04 supportano anche le versioni successive, come Ubuntu 18.04 e 20.04 (nella maggior parte dei casi). |

Come aggiornare la pagina?

Quando si accede all'editor per modificare una pagina, si noterà nella parte in alto la macro Informazioni che si presenta in questo modo:

<<Informazioni(forum="..."; rilasci="15.10 16.04";)>>

Al suo interno è presente la voce rilasci che contiene tra virgolette le versioni con le quali la guida è stata testata. Bene, non occorre far altro che aggiungere il numero di versione di uno dei rilasci di Ubuntu attualmente supportati.

Pertanto, supponendo di aver testato con successo la guida con... ad esempio la 20.04, basta aggiungere il numero all'interno della macro che diviene:

<<Informazioni(forum="..."; rilasci="15.10 16.04 20.04";)>>

Niente di che, vero? ![]()

In generale è buona cosa...

Il discorso può estendersi anche alle pagine già presenti nella colonna delle guide da aggiornare e, ancora più in generale, a qualsiasi tipo di guida presente nel wiki. Come vedi se si incappa in una pagina testata con una versione obsoleta di Ubuntu, per confermarne la validità con una versione supportata è una questione di attimi.

A cura del Gruppo Doc

Vuoi contribuire al Wiki? Comincia subito!

03 January 2021

Choosing the technology behind a mobile app for a startup in 2021: Native vs cross-platform (part 1)

Lorenzo Sfarra (twilight)

What you should know if you are reading this

Our goal is to have a look at the mobile app development technology for startups in 2021, in order to publish an app for Android and an app for iOS with the perfect trade-off between quality and time+resources. How do we choose the best technology to accomplish this task?

First of all, the most accurate answer is:

it depends.

Every startup has different needs, in terms of business, technology, resources (how many developers? and how many of them are senior?) and deadlines.

Assumptions

There are 200000 articles out there about this subject.

This is why I want to list some boundaries that will “limit” our research. So this is not a general article Native vs Cross platform but is a study for a specific case.

That said, let’s start with these assumptions:

- The start-up technological stack has a very strong connection with Google, mostly with Firebase. This is a very important aspect. In the start-up X the most important technology could be Y, so adjust the content of the article accordingly;

- The start-up was providing all the services in web pages only, and the current app is basically a Webview showing an ad-hoc version of the website. I know, I know! Anyway, there is an ongoing process to transform all the services into a full set of (modularised) REST APIs that we can then consume in our app;

- The app does not have heavy processes in terms of device resources, does not do any image/video processing and so on. Anyway, it has to have reliable access to the camera and retrieve the accurate users position through GPS;

- The current technology is React Native, so we already saw both the pros and cons of a not-native approach. But not-native includes a world of solutions, that we will try to consider in this article;

- The strong connection between React and Firebase, to build business web applications in JavaScript with all the power of the Firebase services, is very well explained in a book that I strongly suggest;

- last but not least, I am not vertical on mobile technologies, so your feedbacks are very welcome.

Technologies in this study

I like a lot the category names reported in a very interesting article by Ionic: Comparing Cross-Platform Frameworks.

I will use the same labels that are

Hybrid-Native

Shared codebase, plus native code. Basically:

it allows you to program your user interfaces (UI) in one language that then orchestrates native UI controls at runtime.

Ionic article Comparing Cross-Platform Frameworks

Hybrid-Web

One codebase, running everywhere. Your code does not get “translated” in native components, but

the UI components you use in your app are actually running across all platforms

Ionic article Comparing Cross-Platform Frameworks

So basically you can code with “web” technologies (HTML/CSS/JS) and your UI components will be shown on the device.

Technologies and platforms in the article

According to the previous definitions, we will analyze the following platforms/technologies:

- 100% native code: one app for iOS, one app for Android, with their respective languages, IDEs and so on;

- ReactNative (Hybrid-native);

- Flutter (Hybrid-native);

- NativeScript (Hybrid-native);

- Xamarin (Hybrid-native);

- Ionic (Hybrid-web) ( – that includes PhoneGap / Cordova).

Image from aalpha

Image from aalpha

What’s the study about and how do we try to understand if a choice is better than another one

We will briefly describe pros and cons of every technology.

Then we will compare them at high level and a bit in terms of performances.

At this point we will take into account other important factors:

- Who’s behind them?

- The community around each technology;

- Available libs: active development, time to “port” new features, stability, support and community;

- Trends: we don’t want to adopt a technology that is going to become marginal in the next few years;

- Very few observations related to the UI/UX aspect.

One by one

100% Native

Basically, we have 2 separated projects here: one for Android, one for iOS.

Thanks to the respective IDE (Android Studio and XCode) you will probably be able to build a good skeleton of your app and a good enough flow between the views with no or few code required, with a “drag & drop” approach for elements (buttons, text fields, …). A very good preview is also available, without using a simulator, for example.

XCode interface builder from apple.com

XCode interface builder from apple.com

That’s great. Anyway, all the logic such as performing API calls, dynamically adding/removing content, handling Push notifications, accessing GPS position, accessing camera/gallery and so on, are performed with a platform-specific language: Swift (Objective-C) for iOS, Kotlin (Java) for Android.

All of this just to say that the two apps will live on two separated, parallel projects. You can of course merge some high-level logic regarding how to manage certain flows, but at the end you have to code them separately.

Two separated projects, two separated teams with separated skills. In the worst-case scenario this could double the needed resources.

On the other side you have the maximum reliability when you are going to handle device resources such as the camera or the GPS.

You have all the debugging and profiling power you need in your IDE.

Even regarding 3rd-party libraries (of course here a lot depends on the library itself) you can have less surprises if you are using the specific library for the given platform.

– Firebase

In case of Firebase, an Android native solution is incredibly good, of course, due to the fact that we’re talking about Google solutions.

Also Firebase has an official SDK for iOS, so the native solution is incredibly good for iOS, too.

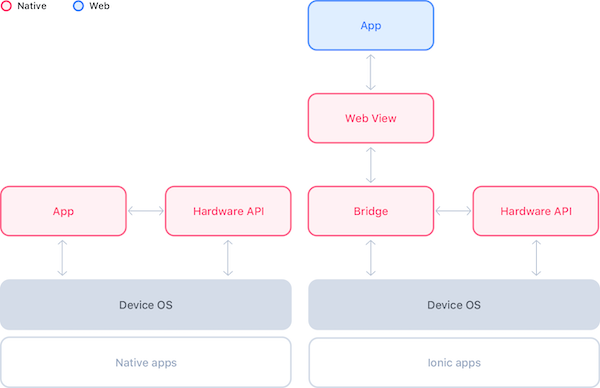

Hybrid-web

We have just one project here: you will code an HTML/JS/CSS solution, that’s it. All the UI is shared between the platforms, so you have a very consistent UI and you don’t need to have different components for different platforms. You can, or you can simply have a different CSS applied for each platform.

For debugging purposes you have different layers to take care of, but most of the job related to the UI can be done in a web-based debugging tool like the Chrome Developer tools. One place, different platforms.

So, we were saying that we have just one project here, and this is something to carefully think about if you are a start-up. Additionally, you can “re-use” web related skills in your team to build your app, substantially decreasing the resources needed to complete it.

How about the device resources?

For the most common tasks such as taking a picture or accessing the GPS location, you can be sure to find a plugin (official or not) that takes care of these tasks for you.

The main idea is that there is a sort of Javascript API system to communicate with the underlying platform.

Ionic

With Ionic you can be sure to have someone in your team that can build a simple app with a small learning curve, due to the fact that it supports the major Javascript frameworks and libraries such as React, Angular and Vue.

It has 120 native device plugins for Camera, GPS, Bluetooth and so on.

It relies on Capacitor or Cordova to execute your web components within wrappers targeted to each platform, with API bindings to access device’s capabilities.

This is the architecture compared to the native one:

Native vs Ionic apps. From the official Ionic doc.

Native vs Ionic apps. From the official Ionic doc.

– Firebase

The Ionic official documentation points to a specific plugin page on GitHub.

This plugin page has a build: failing tag on it (3rd of January 2021): no good.

Let’s see the popularity of the plugin:

| Watch | 68 |

| Stars | 993 |

Anyway, if your choice is Ionic and you want to continue your journey with React, I strongly suggest this book to give you very useful hints on how to build robust web applications with React and Firebase.

For this part, that’s it! In the next part we will focus on the Hybrid-Native solutions.

The post Choosing the technology behind a mobile app for a startup in 2021: Native vs cross-platform (part 1) appeared first on L.S..

11 December 2020

2020-12-11 18:39:36.965 14746-14746/your.bundle E/RNFirebaseMsgReceiver: Background messages only work if the message priority is set to 'high'

This is something you can find in your adb logcat output when sending a push notification (cloud message) and your app is in background.

More specifically, the problem is mostly related to the idle status of your device.

This is explained in a dedicated Firebase doc, particularly in the “Using FCM to interact with your app while the device is idle” section.

If you are sending a message with curl, Postman and so on, you can add something to your JSON in order to set priority.

So a JSON body like this:

{

"to": "token_here",

"notification": {

"title": "hey from Lorenzo",

"body": "great article dude!"

},

"data": {

"body": "normal priority notification",

"title": "here we are",

}

}

becomes:

{

"to": "token_here",

"android": {

"priority": "high"

},

"priority": 10,

"notification": {

"title": "hey from Lorenzo",

"body": "great article dude!"

},

"data": {

"body": "normal priority notification",

"title": "here we are",

}

}

When performing your POST requesto to https://fcm.googleapis.com/fcm/send please remember to add a Content-type: application/json header and a Authorization header with value key=<server_key> that you can retrieve from the “Cloud Messaging” section of your project settings in the Firebase console.

The post Firebase, cloud messaging and problems receiving background notifications appeared first on L.S..

24 October 2020

Il 22 ottobre è stato rilasciato Ubuntu 20.10, nome in codice Groovy Gorilla, supportato fino a luglio 2021.

Come di consueto il Gruppo Documentazione ha organizzato le attività di revisione di alcune pagine wiki .

Molto lavoro rimane ancora da fare: tante guide hanno bisogno di essere aggiornate e verificate con la nuova versione 20.10. Per continuare la revisione della documentazione abbiamo bisogno del tuo aiuto!

Come contribuire

Partecipare alla redazione e all'aggiornamento della documentazione wiki di Ubuntu-it è piuttosto semplice.

Numerose guide contengono sotto l'indice una dicitura simile a questa: «Guida verificata con Ubuntu: 16.04 18.04 20.04».

-

Se una guida è valida anche per Ubuntu 20.10 ma l'informazione non è riportata sotto l'indice della pagina, è sufficiente aggiungere la verifica per il rilascio 20.10.

-

Se una guida contiene istruzioni non valide con Ubuntu 20.10 puoi aggiornarla per adeguare in contenuti al nuovo rilascio.

Come sempre se trovi nomi sbagliati, errori ortografici, collegamenti errati o altre inesattezze facili da modificare non aspettare e correggili senza timore!

A cura del Gruppo Doc

Inizia a contribuire!

12 February 2020

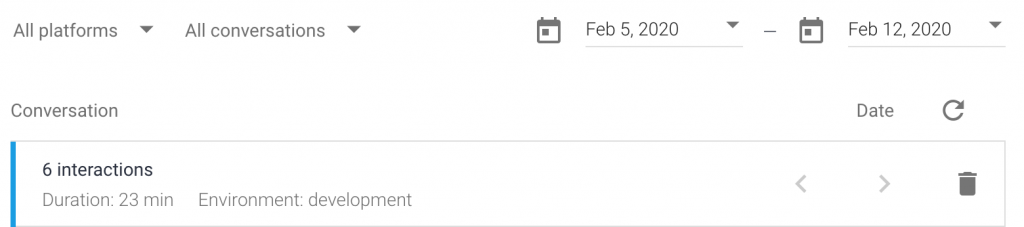

Even if currently it’s a beta feature, you can create multiple versions of your agent and publish them to separate environments.

The problem is that the REST URI bindings do not appear to have been updated in the API definition for this feature.

I wrote an issue in the cloud-php Github project, and John Pedrie, working for the project, asked me to try the gRPC way.

Never did it before, so here’s a guide to help you just in case you are in my situation…hopefully it will be integrated soon!

Assuming you are working with PHP7.3 (and a Debian-based Linux server):

Based on the Install gRPC for PHP doc, on our server (running Ubuntu server 19.10, PHP7.3) I had to install some packages:

sudo apt-get install autoconf libz-dev php-dev php-pear sudo pecl install grpc sudo pecl install protobuf

Let’s modify the /etc/php/7.3/fpm/php.ini file adding the following lines:

extension=grpc.so extension=protobuf.so

Restarting php7.3-fpm:

sudo systemctl restart php7.3-fpm.service

And adding the "grpc/grpc": "^v1.1.0" line to the project composer.json.

Now it’s time to change the code. The usual way is something like:

$sessionClient = new SessionsClient(); $session = $sessionClient->sessionName($projectId, $sessionId); $response = $sessionsClient->detectIntent($session, $queryInput);

And it has to be changed with something like:

$session = $this->_getSessionName($sessionId);

$sessionsClient = new SessionsClient();

$response = $sessionsClient->detectIntent($session, $queryInput);

// WHERE _getSessionName() is:

private function _getSessionName($sessionId)

{

$projectId = $this->_getProjectId();

$environment = $this->_getEnvironment();

return "projects/{$projectId}/agent/environments/{$environment}/users/-/sessions/{$sessionId}";

}

And that’s it.

In the Dialogflow History tab there is still no way to filter conversations by Environment, but there is an Environment indicator in the conversation Detail.

The post Dialogflow API, support for versions and environments appeared first on L.S..

31 January 2020

You can get 2 free months of Skillshare Premium, thanks to this referral link.

With Skillshare Premium you will:

- Get customized class recommendations based on your interests.

- Build a portfolio of projects that showcases your skills.

- Watch bite-sized classes on your own schedule, anytime, anywhere on desktop or mobile app.

- Ask questions, exchange feedback, and learn alongside other students.

That’s it!

- Get inspired.

- Learn new skills.

- Make discoveries.

- Be curious.

I will be more than happy if you can join my classes and give me some feedbacks. The classes are about almost everything that I do in my life (you can check again my skills on the homepage)!..

The post 2 free months of Skillshare Premium! appeared first on L.S..

16 December 2019

You woke up one day and your Android phone contacts disappeared.

You try to perform a Google Search but you only find strange solutions, mostly related to some Samsung stuff, factory resets, uninstalling some app, etc…

Suddenly you realise that your Google Contacts was empty!

Ok, too much context, the solution.

Open your browser to https://contacts.google.com/.

In the top right corner you have a gear, click on it. Then click on Undo changes:

Now you can chose the version of your contacts that you want to restore: minute ago, hours ago, days ago, months ago, years ago….

And that’s it, the time to sync your phone and they’re back!

The post Restore your Google Contacts (for your Android phone, too) appeared first on L.S..

09 December 2019

14 November 2019

Dalla TV, Bobo Vieri sorride sornione come quando giocava a calcio, e ripete "Shave like a bomber!". Tutti gli uomini che se lo ricordano quando giocava a calcio e faceva parlare di se dentro e fuori dal campo, rispondono al sorriso con approvazione.

Quello che fa (bene) Vieri è il testimonial, ci mette la sua bella faccia, e la sua innata simpatia per vendere un prodotto. Una professione a cui si dedicano anche suoi numerosi ex-colleghi giocatori di calcio, e del mondo dello spettacolo.

Mi fa sorridere quindi quando leggo post così che parlando di Chiara Ferragni scrivono di "vuoto pneumatico". Mi pare lapalissiano dire che Chiara Ferragni è una testimonial di se stessa, che sa usare i nuovi canali per comunicare il suo messaggio (qualunque esso sia). Fa marketing, e lo fa bene, visto il giro di soldi che fattura. Nel suo caso poi il fenomeno è così esteso che, chi scrive di lei, o parla di lei, anche in maniera negativa, si fa pubblicità a sua volta, sfruttandone la fama di riflesso.

Denoto in questi articoli - oltre la malizia usata per attirare clic - una certa incapacità di leggere la realtà e di adattarsi al cambiamento di costumi e di mestieri in atto.

Trovo anche sorprendente che i commentatori di cui sopra non riescano a capire come il fenomeno dei testimonial sia in parte sceso dall'Olimpo delle celebrità televisive, per diramarsi nei mille rivoli dei rappresentanti della borghesia. Al giorno d'oggi i testimonial sono anche degli illustri sconosciuti, con cui magari abbiamo fatto una corsetta al parco domenica scorsa.

09 November 2019

(Segue Italiano)

🇬🇧🇺🇸 Last october I attended Ubucon Europe 2019, at Sintra in Portugal. Still need some time to gather the right words to explain how well I felt standing there with Ubuntu mates, and how many different good talks I saw.

Meanwhile, you can take a look at the video of my talk, where I speak about my running story: how I began running, why I still run, and why (almost) everybody can do it. Oh! Obviously I explain also what open source software you can use to track safely and securely your runs.

Let me know what you think about it! :-)

🇮🇹 Lo scorso ottobre ho partecipato a Ubucon Europe 2019, a Sintra in Portogallo. Ho bisogno di ancora un po' di tempo per mettere insieme le parole giuste per spiegare come mi sono sentito stare lì con gli amici ubunteri, e quanti bei talk ho sentito.

Intanto, potete dare un'occhiata al video del mio talk, dove parlo della mia storia di corsa: come ho cominciato, perché corro ancora e perché (quasi) tutti possono farlo. Oh! Ovviamente spiego anche che software open source si può usare per tracciare in le proprie corse in modo sicuro.

Fatemi sapere cosa ne pensate! :-)

Thanks very much Ubuntu & Canonical for funding my travel expenses!

(The picture in this post is from Marco Trevisan on Twitter)

19 April 2019

In occasione della visita in Italia, ci sono state parecchie critiche negative su Greta Thumberg, la ragazzina svedese che ha lasciato la scuola per una sua personale battaglia a favore dell'ambiente, e sulla sua azione per contrastare il cambiamento climatico. Ci sono stati anche attacchi alla sua persona, tanto infondati quanto ignobili, specie se si considera la sua giovane età.

La cosa che sfugge a chi è abituato a leggere solo i titoli dei giornali, e in base a questi farsi un'opinione, è che le aziende petrolifere spendono milioni di dollari per spargere fake news, finanziare politici e rifarsi un'immagine.

Cioè: mentre io sto lì a separare la finestrella di plastica dal resto della busta di carta prima di buttare entrambe nella rispettiva raccolta differenzia "le grandi compagnie petrolifere, benché ufficialmente sostenitrici della lotta ai cambiamenti climatici, operano in realtà nell’ombra al fine di conservare i loro business". Senza contare "le grandi banche internazionali hanno versato 1.900 miliardi di dollari al comparto delle fonti fossili (gas e carbone inclusi)".

Se dopo tutto questo restate indifferenti, se non ve ne frega assolutamente niente che il pianeta Terra sia sempre più invivibile, se pensate che i nostri figli e nipoti che si troveranno a gestirlo in qualche maniera si arrangeranno, dovreste pensare a cosa tenere di più caro (i soldi!) e valutare la possibilità che continuare a finanziare - 100 miliardi di dollari all'anno, di cui 17 miliardi dal Governo Italiano - le fonti di energia fossili è una pessima idea per il proprio portafoglio.

La foto di Greta è tratta da Wikipedia.

12 April 2019

Tediato oltre misura dall'invasiva pubblicità su Twitter del noto marchio di diavolerie elettroniche, che intende rifarsi la verginità sulla privacy a forza di video emotivamente pucciosi, ho risposto a tono a un suo tweet. Sono stato subito bloccato.

Morale della favola: mi sarà impossibile vedere le prossime pubblicità ipocrite di Apple. Grazie Apple!

01 March 2019

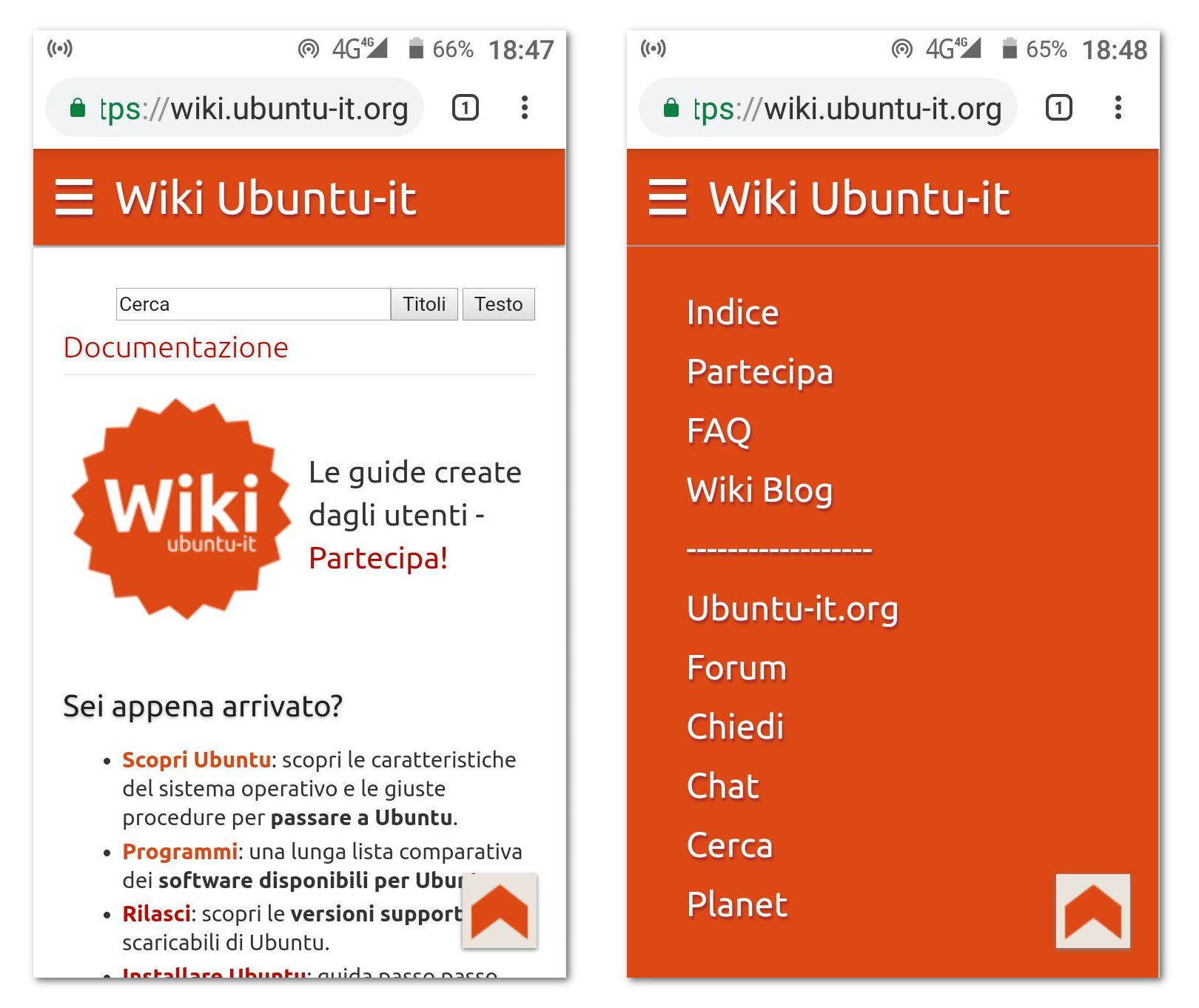

Il wiki di Ubuntu-it è stato aggiornato per ottimizzare la lettura dei testi da smartphone ![]()

Le modifiche sono già attive da un paio di settimane, ma è stato necessario fare alcuni aggiustamenti per renderle davvero efficaci. Potrebbe essere necessario effettuare un refresh o ripulire la cache del browser per visualizzare la nuova grafica; a parte questo potrete leggere la documentazione, la newsletter e tutte le altre pagine del wiki da smartphone senza ulteriori problemi.

Al momento la modifica entra in funzione solo quando la larghezza della finestra è a misura di smartphone, nella cosiddetta modalità "portrait". In tal caso apparirà il nuovo header semplificato con il classico pulsante per il menù a scomparsa. Si noterà che in questa modalità non sono presenti i link di login/modifica/ecc.

Ruotando lo smartphone (modalità "landscape"), si tornerà a visualizzare il sito come su desktop.

Questa impostazione è stata scelta perché il wiki fu a suo tempo impostato con grafiche a larghezza fissa e tabelle anche complesse che si adattano prevalentemente a una visualizzazione da desktop. È possibile quindi incappare in pagine con contenuti che mal si adattino alla larghezza dei piccoli schermi, pertanto ruotando il dispositivo si ha comunque la possibilità di visualizzare la grafica originaria.

Ad eccezione di alcune pagine che dovranno essere manualmente ritoccate e inevitabili piccoli ritocchi alle impostazioni del wiki, i risultati sono andati oltre alle aspettative. Quindi non è escluso che più in là il responsive design possa essere esteso fino alla visualizzazione su desktop.

Aspetti tecnici

Il wiki utilizza la piattaforma MoinMoin. Il suo aspetto grafico è dovuto all'introduzione del tema Light nell'ormai lontano 2011.

Per chi fosse interessato le modifiche hanno riguardato giusto tre file:

-

light.py: al suo interno, insieme al vecchio header è stato inserito il codice html e javascript per disegnare il nuovo header in stile mobile.

-

common.css - screen.css: sono questi i due principali file responsabili per l'aspetto stilistico del wiki. Al loro interno sono state inserite media queries per adattare gli elementi delle pagine e per rendere alternativamente visibile il nuovo o il vecchio header a seconda della larghezza dello schermo.

In definitiva MoinMoin ci ha piacevolmente sorpreso mostrando un buon grado di adattabilità ![]()

Buona consultazione a tutti!

A cura del Gruppo Doc

Vuoi contribuire al Wiki? Comincia subito!

19 February 2019

Introduction: Node + express + body-parser + Shopify?

Are you using Node/express/body-parser and Shopify, and (you would like to use) its webhooks?

If the answer is YES to the questions above, I am going to suggest here a way to solve a common problem.

NOTE: This and much more is covered in the Coding Shopify webhooks and API usage: a step-by-step guide class on Skillshare!

The problem

Body-parser does an amazing work for us: it parses incoming request bodies, and we can then easily use the req.body property according to the result of this operation.

But, there are some cases in which we need to access the raw body in order to perform some specific operations.

Verifying Shopify webhooks is one of these cases.

Shopify: verifying webhooks

Shopify states that:

Webhooks created through the API by a Shopify App are verified by calculating a digital signature. Each webhook request includes a base64-encoded X-Shopify-Hmac-SHA256 header, which is generated using the app’s shared secret along with the data sent in the request.

We will not go into all the details of the process: for example, Shopify uses two different secrets to generate the digital signature: one for the webhooks created in the Admin –> Notifications interface, and one for the ones created through APIs. Anyway, only the key is different but the process is the same: so, I will assume that we have created our webhooks all in the same way, using JSON as object format.

A function to verify a webhook

We will now code a simple function that we will use to verify the webhook.

The first function’s param is the HMAC from the request headers, the second one is the raw body of the request.

function verify_webhook(hmac, rawBody) {

// Retrieving the key

const key = process.env.SHOPIFY_WEBHOOK_VERIFICATION_KEY;

/* Compare the computed HMAC digest based on the shared secret

* and the request contents

*/

const hash = crypto

.createHmac('sha256', key)

.update(rawBody, 'utf8', 'hex')

.digest('base64');

return(hmac === hash);

}

We use the HMAC retrieved from the request headers (X-Shopify-Hmac-Sha256), we retrieve the key stored in the .env file and loaded with the dotenv module, we compute the HMAC digest according to the algorithm specified in Shopify documentation, and we compare them.

We use the crypto module in order use some specific functions that we need to compute our HMAC digest.

Crypto is a module that:

provides cryptographic functionality that includes a set of wrappers for OpenSSL’s hash, HMAC, cipher, decipher, sign, and verify functions.

NOTE: it’s now a built-in Node module.

Retrieving the raw body

You have probably a line like this one, with or without customization, in your code:

// Express app const app = express(); app.use(bodyParser.json());

So your req.body property contains a parsed object representing the request body.

We need to find a way to “look inside the middleware” and to add somehow the information regarding the request status, using our just-defined function: is it verified or not?

Now, we know that the json() function of body-parser accepts an optional options object, and we are very interesting to one of the possible options: verify.

The verify option, if supplied, is called as verify(req, res, buf, encoding), where buf is a Buffer of the raw request body and encoding is the encoding of the request. The parsing can be aborted by throwing an error.

That’s it, we are going to use it like this.

Let’s change the json() call in this way:

// Express app

const app = express();

app.use(bodyParser.json({verify: verify_webhook_request}));

And we create the function verify_webhook_request() according to the signature documented before:

function verify_webhook_request(req, res, buf, encoding) {

if (buf && buf.length) {

const rawBody = buf.toString(encoding || 'utf8');

const hmac = req.get('X-Shopify-Hmac-Sha256');

req.custom_shopify_verified = verify_webhook(hmac, rawBody);

} else {

req.custom_shopify_verified = false;

}

}

Basically, we check if the buffer is empty: in such case, we consider the message not verified.

Otherwise, we retrieve the raw body using the toString() method of the buf object using the passed encoding (default to UTF-8).

We retrieve the X-Shopify-Hmac-Sha256.

After we have computed the verify_webhook() function, we store its value in a custom property of the req object.

Now, in our webhook code we can check req.custom_shopify_verified in order to be sure that the request is verified. If this is the case, we can go on with our code using the req.body object as usual!

Another idea could be to stop the parsing process: we could do this throwing an error during the verify_webhook_request function.

Conclusion

Please leave your comment if you want to share other ways to accomplish the same task, or generically your opinion.

NOTE: Remember that this and much more is covered in the Coding Shopify webhooks and API usage: a step-by-step guide class on Skillshare!

The post Node, body-parser and Shopify webhooks verification appeared first on L.S..

07 February 2019

Ubuntu 14.04 LTS Trusty Tahr raggiungerà la fine del suo ciclo di vita il 30 aprile 2019 e, da allora, sarà disponibile Ubuntu 14.04 LTS - ESM, ovvero Extended Security Maintenance. Si tratta di una funzionalità disponibile con Ubuntu Advantage, il pacchetto di supporto commerciale di Canonical, oppure che può anche essere acquistata su base stand-alone. L'Extended Security Maintenance è stato creato per aiutare a semplificare il processo di migrazione verso le nuove piattaforme aggiornate, mantenendo gli standard di conformità e sicurezza.

L'introduzione di Extended Security Maintenance per Ubuntu 12.04 LTS è stato un passo importante per Ubuntu, portando patch di sicurezza critiche e importanti oltre la data di fine vita di Ubuntu 12.04. ESM viene utilizzato dalle organizzazioni per risolvere problemi di sicurezza e conformità mentre gestisce il processo di aggiornamento a una versione più recente di Ubuntu in grado di garantire pieno supporto. La disponibilità di ESM per Ubuntu 14.04 significa che l'arrivo dello status di End of Life di Ubuntu 14.04 LTS Trusty Tahr nell'aprile 2019 non dovrebbe influire negativamente sulla sicurezza e sulle conformità delle organizzazioni che lo utilizzano ancora come sistema operativo in essere. In totale, ESM ha fornito oltre 120 aggiornamenti, comprese correzioni per oltre 60 vulnerabilità con priorità alta e critica, per gli utenti di Ubuntu 12.04.

Ancora una volta, lo abbiamo segnalato anche in passato sulla newsletter (Ubuntu in prima linea per la sicurezza), risulta estremamente chiaro come Canonical metta la sicurezza al centro di Ubuntu, oltre che nelle pratiche e nella architettura dei prodotti a esso relativi sia lato business che lato consumer.

Fonte: blog.ubuntu.com

05 February 2019

|

Ad Aprile cesserà il supporto per la gloriosa Ubuntu 14.04. Fortunatamente i computer che funzionano con Ubuntu 14.04 supportano anche le versioni successive, come Ubuntu 16.04 e 18.04 (nella maggior parte dei casi). |

Come aggiornare la pagina?

Quando si accede all'editor per modificare una pagina, si noterà nella parte in alto la macro Informazioni che si presenta in questo modo:

<<Informazioni(forum="..."; rilasci="13.10 14.04";)>>

Al suo interno è presente la voce rilasci che contiene tra virgolette le versioni con le quali la guida è stata testata. Bene, non occorre far altro che aggiungere il numero di versione di uno dei rilasci di Ubuntu attualmente supportati.

Pertanto, supponendo di aver testato con successo la guida con... ad esempio la 18.04, basta aggiungere il numero all'interno della macro che diviene:

<<Informazioni(forum="..."; rilasci="13.10 14.04 18.04";)>>

Niente di che, vero? ![]()

In generale è buona cosa...

Per ovvi motivi abbiamo messo in primo piano le pagine sui portatili testate con la 14.04. Il discorso si estende comunque anche alle pagine già presenti nella colonna delle guide da aggiornare e, ancora più in generale, a qualsiasi tipo di guida presente nel wiki.

Come vedi se si incappa in una pagina testata con una versione obsoleta di Ubuntu, per confermarne la validità con una versione supportata è una questione di attimi.

A cura del Gruppo Doc

Vuoi contribuire al Wiki? Comincia subito!

25 January 2019

Con l'inizio del 2019 arriva un'importante novità riguardante la Documentazione Wiki.

Il Gruppo Doc ha deciso di lasciare maggiore iniziativa agli utenti del wiki in materia di creazione di nuove guide e aggiornamento delle pagine esistenti.

Cosa significa? Facciamo un passo indietro...

Da sempre il Gruppo Doc si è preoccupato di assistere e supervisionare il lavoro svolto dagli utenti. Cioè essere presenti sul forum per valutare se una guida proposta fosse necessaria o attinente agli scopi della documentazione... oppure, una volta che un utente ha svolto il lavoro, tempestivamente revisionare e adattare i contenuti agli Standard, inserire il link alla guida nel portale di appartenenza, ecc..

Tutto questo per garantire una crescita razionale e ben ordinata della documentazione.

Il lato debole di questo metodo di lavoro è che non sempre può essere garantita una presenza continuativa da parte dello staff, sebbene negli ultimi sette anni ci siamo in massima parte riusciti ![]()

La nostra attività di supporto e supervisione andrà avanti, è stato però deciso di aggiornare l'iter in modo tale che anche in nostra assenza un utente possa agire di sua iniziativa. Questo per evitare appunto che una guida rimanga a lungo bloccata prima di essere pubblicata.

In sostanza si è cercato di mantenere le buone pratiche attuate in questi anni e di aggiungere un pizzico di responsabilità in più da parte degli utenti.

Queste le pagine che riportano le principali modifiche al metodo di lavoro:

-

GruppoDocumentazione/Partecipa: mostra gli step da seguire, con alcune novità come la possibilità di aggiornamento degli indici dei portali tematici e l'aggiornamento della tabella delle guide svolte.

-

GuidaWiki/Standard: schematizzata la parte del formato del wiki-testo, sono state introdotte le frasi standard e alcuni accorgimenti stilistici che chiediamo agli utenti di seguire quanto più possibile.

-

GruppoDocumentazione/Partecipa/FAQ: logico adeguamento a quanto riportato sopra.

Un saluto e che il 2019 porti buone cose alla Documentazione Wiki ![]()

A cura del Gruppo Doc

Vuoi contribuire al Wiki? Comincia subito!

19 January 2019

- PCmanFm Menu Stampa: nuova guida per abilitare la funzionalità di stampa dal menù contestuale del file manager PCmanFM.

- Aggiornare Kernel: aggiornamento procedura di installazione del kernel e inserimento di nuove pagine di riferimento.

- Apper: nuova guida per il gestore di pacchetti opzionale per Kubuntu.

- AsusX53S-K53SC: resoconto di installazione di Ubuntu su questo portatile.

- Acer Aspire 5612wlmi: resoconto di installazione di Ubuntu su questo portatile.

- Acer Aspire ES1-524: resoconto di installazione di Ubuntu su questo portatile.

- Lenovo Yoga 730_13IWL: resoconto di installazione di Ubuntu su questo portatile.

- Epson Multi: aggiornamento della guida per installare stampanti mono o multifunzione Epson su Ubuntu.

- Scanner Epson: aggiornamento della guida per installare scanner Epson su Ubuntu.

- Installare Ubuntu: revisione dell'intera guida con l'inserimento di nuovi contenuti.

- Accelerazione Hardware: nuova guida che illustra la procedura per abilitare l'accelerazione hardware su Chromium e gli altri browser da esso derivati, quali Google Chrome, Opera e Vivaldi.

- Opera: aggiornamento della guida per le nuove versioni del browser.

- Thunderbird: aggiornamento della guida per il famoso client di posta elettronica libero, che nelle ultime versioni utilizza un nuovo motore di rendering.

- CMake Gui: aggiornamento guida su questo strumento, utile per controllare il processo di compilazione di software.

- Pip: nuova guida all'installazione e al primo utilizzo su Ubuntu di pip, gestore di pacchetti per Python.

- Stardict: revisione completa della guida.

08 December 2018

Tempo fa avevo scritto questo articolo, in cui indicavo i passi per l’installazione dello scanner in ogetto .

Recentemente ho fatto l’aggiornamento da Xenial Xerus a Bionic Beaver, e nel seguire le indicazioni presenti nell’articolo indicato prima, lo scanner ancora non veniva rilevato, cosi facendo la ricerca nel wiki italiano (qui la guida), ho scoperto che vanno aggiunti dei passaggi aggiuntivi, quindi riepilogando:

- scaricare i driver a questo indirizzo;

- installare i tre pacchetti, iscan-data_[versione corrente]_all.deb, iscan_[versione corrente]~usb0.1.ltdl7_i386.deb e iscan-plugin-gt-s600_[versione corrente]_i386.deb, oppure lanciare lo script install.sh presente all’interno della cartella (prima va reso eseguibile)

- installare i pacchetti libltdl3, libsane-extras e sane;

- editare il file /etc/sane.d/dll.conf e commentare la riga #epson;

- editare il file /etc/udev/rules.d/45-libsane.rules e aggiungere le seguenti righe:

# Epson Perfection V10

SYSFS{idVendor}=="04b8", SYSFS{idProduct}=="012d", MODE="664", GROUP="scanner"

- editare il file /etc/udev/rules.d/79-udev-epson.rules e aggiungere le seguenti righe:

# chmod device EPSON group

ATTRS{manufacturer}=="EPSON", DRIVERS=="usb", SUBSYSTEMS=="usb", ATTRS{idVendor}=="04b8", ATTRS{idProduct}=="*", MODE="0777"

- digitare il seguente comando, in base all’architettura del proprio pc:

Per architettura 32 bit sudo ln -sfr /usr/lib/sane/libsane-epkowa* /usr/lib/i386-linux-gnu/sane

Per architettura 64 bit sudo ln -sfr /usr/lib/sane/libsane-epkowa* /usr/lib/x86_64-linux-gnu/sane

- infine digitare il seguente comando per riavviare udev:

sudo udevadm trigger

28 November 2018

Introduction: Firebase CLI

According to the github page of the firebase-tools project, the firebase cli can be used to:

- Deploy code and assets to your Firebase projects

- Run a local web server for your Firebase Hosting site

- Interact with data in your Firebase database

- Import/Export users into/from Firebase Auth

The web console is fine for a lot of stuff.

But let’s see what we can do with the CLI, and let’s check what we CANNOT do without it.

Installation

Ok, easy.

Assuming you have npm installed, run the following command:

npm install -g firebase-tools

You will now have the command firebase, globally.

Now, run:

firebase login

to authenticate to your Firebase account (this will open your browser).

Firebase tasks

Seleting projects

List your firebase projects:

firebase list

You can then select one of them with

firebase use <project>

Cloud Functions Log

A common thing you would like to do is looking at the logs.

This is possible with:

firebase functions:log

At this point I think there is no way to “listen” for changes in the log, that would be a very useful feature.

The

gcloud app logs tail

sadly does not help here, even if the current selected project is the firebase one.

If you have some tips about it, I will be more than happy to edit this article.

Configuration

The functions configuration is handled through some commands:

firebase functions:get|set|unset|clone

to retrieve|store|remove|clone project configuration (respectively).

Emulate locally

Running

firebase functions:shell

will let you choose which of your functions to emulate locally.

You can then choose the method (get/head/post/put/patch/del/delete/cookie/jar/default) and the test data to start the emulation.

Delete functions

You can then delete one or more cloud functions with:

firestore functions:delete <function_name>

Deploy and serve locally

To serve your project with cloud functions locally, you can run:

firebase serve

When you’re ready to deploy your firebase project, you can run:

firebase deploy

Accounts management

With the firebase cli you can both import and export Firebase accounts with the:

firebase auth:import|export <file>

Surprisingly enough, import import accounts from a file, and and export will export accounts to a file.

Database

I will skip this part. It’s very well documented everywhere in the firebase ecosystem.

Firestore

Here we are.

What we can do with Firestore with our CLI? Almost nothing, I am afraid.

Right now you have only two things we can accomplish.

But we can use gcloud and gsutil to perform other operations, lick exporting / importing data.

Be sure to be logged in with

gcloud auth login

If you are already logged in with different accounts, you can list the accounts with

gcloud auth list

and select one (if the one you need is not the active one) with

gcloud config set account myaccount@gmail.com

At this point, let’s select our project.

gcloud projects list

to list all the projects and

gcloud config set project project_name

to select our project.

Exporting data

First of all, we need a Storage Bucket.

gsutil ls

to see the list of possible buckets to use.

Let’s say that we want to export our data to gs://myproject-abcd.appspot.com/ :

gcloud firestore export gs://myproject-abcd.appspot.com/

You can even export only some collections:

gcloud firestore export gs://myproject-abcd.appspot.com/ --collection-ids=[COLLECTION_ID_1],[COLLECTION_ID_2]

Importing data

You can imagine it, right?

gcloud firestore import gs://myproject-abcd.appspot.com/2019-12-23T23:54:39_76544/

The operation takes some time (proportional to the data size that has to be imported). You can safely close your terminal, the operation will continue.

Checking operations status

Import and export can take time (import takes time even with a very small database).

To list the operations:

gcloud firestore operations list

And you will see something like:

done: true

metadata:

'@type': type.googleapis.com/google.firestore.admin.v1.ImportDocumentsMetadata

endTime: '2019-12-23T15:48:03.747509Z'

inputUriPrefix: gs://myproject-abcd.appspot.com/2019-12-23T23:54:39_76544

operationState: SUCCESSFUL

progressBytes:

completedWork: '2601'

estimatedWork: '2601'

progressDocuments:

completedWork: '8'

estimatedWork: '8'

startTime: '2019-12-23T15:47:25.089261Z'

name: projects/myproject-abcd/databases/(default)/operations/AiAydsadsadsadsadVhZmVkBxJsYXJ0bmVjc3Utc2Jvai1uaW1kYRQKLRI

response:

'@type': type.googleapis.com/google.protobuf.Empty

Indexes (read)

You can look at your indexes:

firebase firestore:indexes

This will list the indexes in a JSON-form of array of objects described as the following one:

{

"indexes": [

{

"collectionId": "<collection_id>",

"fields": [

{

"fieldPath": "<field_name_one>",

"mode": "ASCENDING|DESCENDING"

},

{

"fieldPath": "<field_name_two>",

"mode": "ASCENDING|DESCENDING"

}

]},

{..}

]}

We cannot perform other operations over indexes.

Collections and documents: delete recursively

It’s easy from the web console to delete a document, and it’s easy to do it programmatically.

It’s easy on the CLI, too.

But the nightmare of the web console (and of the programmatic approach, too) is that it does not exist a simple and fast way to recursively delete a collection.

This is luckily possible with the CLI.

You can recursively delete a collection by using:

firebase firestore:delete --recursive <collection>

Bonus: delete all collections

Now, assuming you are testing something and your firestore is full of garbage, you might want to start from scratch deleting every collection.

This is possible running:

firebase firestore:delete --all-collections

If you are looking at your database in the firebase console, please remember to refresh if the UI is not updated (that means that you still see the root collections).

Conclusion

This concludes the article for now.

I hope that the Firestore-side will be developed with other features and commands, because right now is very limited.

One of the most feature I can think of, generally speaking, would be the chance to “tail” logs in the shell.

I would be more than happy if someone can integrate with useful tools and additional stuff.

The post Exploring Firebase CLI with some Firestore tips appeared first on L.S..

26 October 2018

Ecco le novità introdotte nella documentazione della comunità italiana di Ubuntu.

Aggiornamenti per il rilascio di Ubuntu 18.10!

Questo mese ha visto l'arrivo della nuova versione Ubuntu 18.10. Si tratta di una versione "intermedia" con supporto di 9 mesi e sarà quindi supportata fino a Luglio 2019. Come di consueto il Gruppo Documentazione si è attivato per aggiornare una corposa lista di pagine fra cui quelle relative al download, all'installazione e all'aggiornamento del sistema, ai repository.. e molte altre ancora.

Per maggiori dettagli consulta la pagina GruppoDocumentazione/Cosmic.

Portale Ambiente Grafico

-

Dolphin Menu Stampa: ottenere voci relative alle funzionalità di stampa nel menù contestuale del file manager Dolphin in KDE5 attivabile tramite clic destro.

Portale Amministrazione Sistema

-

Apt: istruzioni sull'utilizzo di APT, il sistema di gestione dei pacchetti .deb, predefinito in Ubuntu.

Portale Hardware

-

Samsung NP350V5C-S0AIT: resoconto di installazione di Ubuntu su questo portatile.

-

Hp15-bs148nl: resoconto di installazione di Ubuntu su questo portatile.

Portale Installazione

-

Creazione LiveUsb: aggiornata la tabella dei programmi utili per la creazione di chiavette USB avviabili con Ubuntu.

Portale Internet e Rete

-

Firefox ESR: installazione e utilizzo del browser web Firefox ESR, versione ufficiale con supporto esteso di Firefox.

-

Irssi: istruzioni utili per l'installazione e l'utilizzo di Irssi, un client IRC che permette di comunicare in modalità testuale dalla riga di comando.

-

MlDonkey: installazione e utilizzo di questo programma per il peer to peer estremamente potente con funzione client e server.

-

Pidgin: installazione e configurazione di questo client di messaggistica istantanea multi-protocollo.

-

Telegram: installare la versione desktop di Telegram su Ubuntu.

Per maggioro informazioni, consulta la pagina Lavoro Svolto/2018.